El tiempo en tus manos VR: Detrás de las cámaras

19 SEP 2016 8:05

Os invitamos a indagar en parte de los secretos sobre la realización y post-producción del sorprendente episodio: El Tiempo en tus manos. Descubriréis el proceso para dar vida a la aclamada serie de RTVE, El Ministerio del Tiempo, aprovechando las virtudes de la realidad virtual. El estudio encargado de realizar el primer episodio de realidad virtual interactivo en el mundo no es otro que Future Lighthouse, sin duda expertos en narrar historias inmersivas.

El Ministerio del Tiempo VR

Introducción

Si aún queda alguien que no conozca a Future Lightouse os animamos a escuchar el Rovcast 51, en el que hablamos sobre el Ministerio VR con Roberto Romero (CTO) y Carolina Avedano (Directora de Marketing), a los que agradecemos toda la información que nos han facilitado para realizar este artículo.

Detrás de Future Lightouse hay todo un equipo de profesionales. Cuentan con guionistas, creadores visionarios, publicistas, ingenieros, programadores, desarrolladores, animadores y un largo etc. Entre sus trabajos más importantes destacan: El tiempo en tus manos, el episodio interactivo en 360 estereoscópico sobre el Ministerio del Tiempo, del que hablaremos en este artículo; o su reciente trabajo Tomorrow.

El Tiempo en tus manos

La idea surge en junio de 2015, donde Future Lighthouse decide "cruzar la puerta" del Ministerio del Tiempo y proponer al área de Análisis y Nuevos Proyectos de Radio Televisión Española (RTVE) lo que será el primer episodio interactivo para realidad virtual en España. La experiencia, bautizada como "El tiempo en tus manos", permite al usuario interactuar con algunos de los protagonistas de la serie y recorrer con ellos parte del Ministerio. El espectador se convierte en un candidato a funcionario del Ministerio del Tiempo, por lo que deberá realizar un examen interactivo para comprobar si es apto para dicho puesto de trabajo.

Rodaje

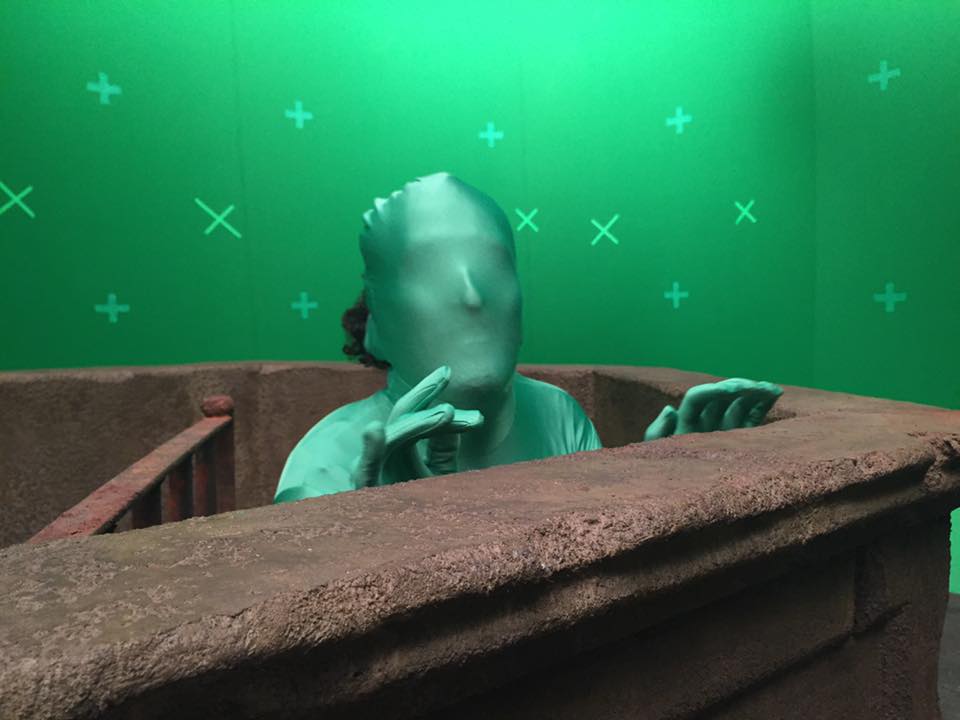

El rodaje, de dos días de duración, se realizó en los escenarios originales de la serie. El equipo apostó por realizar una experiencia lo más inmersiva posible mediante una grabación en 360º estereoscópica con partes interactivas y sonido binaural. Para ello se utilizó un rig propio con dos cámaras de alta calidad. Contaron con Antonio García Serrano (Zakato 360) para esta labor, un verdadero experto en estereoscopía.

"Para que una grabación en 360º tenga sentido, cada ángulo tiene que haber algo interesante para el espectador. Lo teníamos en cuenta, y eso añadió un punto de dificultad, ya que había que sincronizar las acciones que ocurrían en diferentes ángulos de grabación".

Con este sistema el equipo de grabación se conseguían planos de 90º, dividiendo así las escenas en cuatro cuadrantes de manera que la acción no pasara de uno a otro. Pero cuando por exigencia de guion los personajes debían pasar de un cuadrante a otro, suponía un problema para “coser” la esfera. La solución fue interponer un atrezzo en medio. Por ejemplo, como se ve en la segunda secuencia, en el claustro, utilizando una columna para unir ambos cuadrantes.

Durante el rodaje, y dada la tecnología en ese momento, se sacrificaron aspectos como el movimiento. Realizar una secuencia en travelling no fue viable (algo que han sido capaces de realizar posteriormente y de manera espectacular en Tomorrow mediante render). También se eliminó el cuerpo (avatar), algo que no fue posible por tiempo y presupuesto.

La postproducción

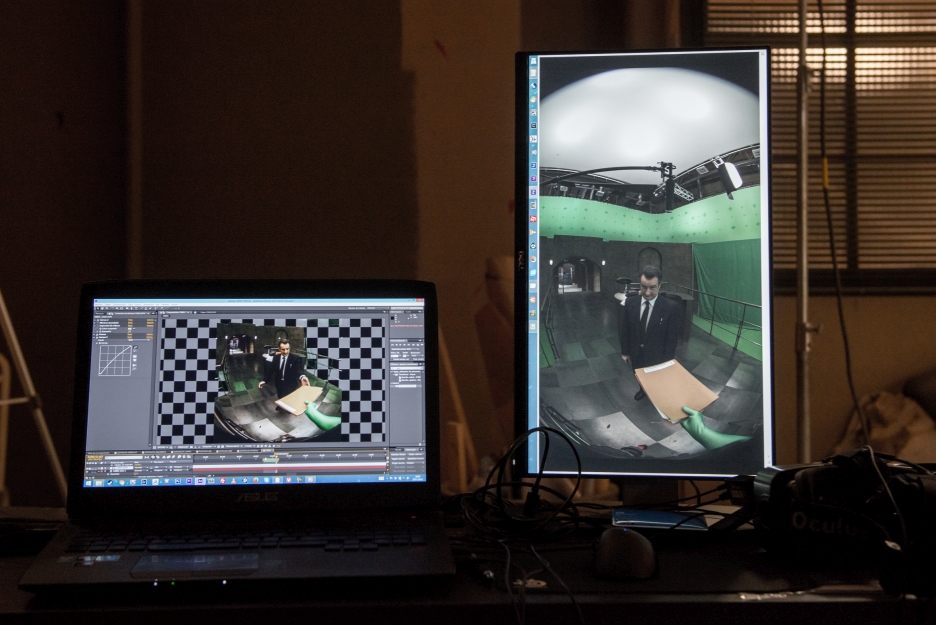

Tras cinco meses de preproducción, catorce versiones de guion y dos días de rodaje, se pasó a la postproducción, tarea en la que se fue cosiendo imagen y renders en 3D de los escenarios digitales. Más tarde sería el turno de realizar un complejo proceso de efectos especiales, usando assets originales de la serie que les cedió USERt38, para que después José Jucas realizara esta integración. A su vez, el equipo, y de la mano de Néstor Viña, llevó a cabo el desarrollo de los exámenes interactivos que se realizan en la experiencia. No fue un proceso fácil, ya que la usabilidad y el confort del usuario estaba en juego.

Dificultades

El equipo tenía la enorme responsabilidad de igualar la calidad de una serie de televisión de prestigio, de manera que fuera lo más parecida posible. Alcanzar el mismo aspecto y calidad de VFX en una producción 360 estereoscópica trabajando con dos imágenes a la vez no resultó tarea fácil.

"En este momento es donde empieza mi trabajo. Recibo por un lado las imágenes 360º por duplicado, una para cada ojo y los renders 3D también para ambos ojos. Mi trabajo consiste en juntar ambas cosas, eliminar los cromas, sustituir techos, borrar elementos que no deberían verse como focos e igualar el color y la luz para que los entornos 3D parezcan parte del decorado real. Todo esto asegurando de que cualquier operación que haga sobre la imagen de uno de los ojos ha de replicarse exactamente igual en el otro ojo, pero compensando la desviación horizontal de ese ojo para evitar problemas de estereoscopía; es decir, que al verlo en 3D tus ojos no noten nada raro en ese punto.” - José Jucas, VFX.

Casi todo este trabajo lo realizaron utilizando Nuke de The Foundry, un potente programa de postproducción con muchas herramientas para trabajar con vídeo estereoscópico. A pesar de esto, las correcciones de alineación tuvieron que hacerlas a mano en determinadas ocasiones. Una vez alineados el fondo real con el 3D y eliminados los cromas, fueron fusionando los bordes creando extensiones de suelo y techo que no saltase a la vista. Se trató de un aspecto delicado, pues si no se hacía bien, al usar las gafas VR podríamos encontrar saltos repentinos de profundidad entre el decorado y el fondo 3D.

“El rodaje duró dos días. El proceso de postproducción… algo más: cuatro meses, desde finales de diciembre hasta entrando marzo. Sin duda, para todo el equipo fue una verdadera experiencia de aprendizaje, ya que era la primera vez que combinábamos el trabajo 360º con la estereoscopía”.

Focos de atención y sonido binaural

Otro de los puntos importantes en la grabación 360 son los focos de atención, captar la mirada del espectador. En el caso del Ministerio VR, la acción transcurre en primera persona, somos parte de la historia, por lo que los personajes te hablan directamente a ti, mirándote de frente. Pero, ¿cómo se lleva al espectador de un foco de atención a otro? El equipo utilizó varias estrategias. Por ejemplo, mediante un elemento visual, algo que se te cruza y te llama la atención guiándote hasta el segundo foco. Otra herramienta importantísima es el audio.

Se apostó por sonido binaural. El encargado de la parte técnica fue José Luis Lara Romero (sonidista en La Taiga, empresa de producción de audio). La captación de audio la realizaron de modo tradicional. La ventaja de grabar por sectores fue que pudieron operar con la pértiga en el lugar oportuno, contando además, con la ventaja de que los techos se sustituirían en post-producción mediante software.

Cada personaje contaba con micro de corbata y, como la acción transcurría en primera persona, gran parte de las acciones sucedían con los actores hablando a poca distancia de la cámara, por lo que la captación les resultó sencilla en este aspecto. Donde apareció el verdadero reto fue en la post-producción. El sonido debía ser de calidad, bien posicionado y que respondiera bien al “head-tracking” o movimiento de cabeza. Realizaron diversas pruebas antes del rodaje. Una primera opción fue añadir fuentes de audio discretas en Unity y utilizar alguna herramienta de especialización para realizar la esfera. Este método les resultó muy útil para la parte interactiva de la experiencia, donde se realiza el examen. Pero la parte cinematográfica necesitaría más control sobre el audio.

Tradicionalmente en la Taiga han trabajado con Pro Tools, una potente herramienta de sonido que en una ambientación 360 no es suficiente. Resultaba imprescindible poder ver el vídeo durante la ambientación y mezcla de la pieza. A pesar de poder importar el vídeo en dicho programa, este se vería aplanado. La solución fue la suite TwoBigEars “Spatial Workstation”. Esta solución suponía que tuvieran un paquete completo de herramientas para poder trabajar en Pro Tools y entregar una master audio que incluía una solución de integración en Unity.

De esta manera podían reproducir vídeo esférico y navegar por él con el audio reaccionando al giro. A pesar que la interfaz del plug-in resultaba relativamente sencilla y permitía colocar el audio en una posición concreta y una distancia especifica con una reverberación exacta, el resultado no era para nada tan exacto y la mezcla llevó a Jose Luis, y equipo, mucho trabajo.

“A pesar de trabajar en una esfera de 360º, la audición final se realizaría en auriculares y en esta reducción (y aunque el plugin realiza funciones HRTF para conservar la máxima sensación espacial posible) aparecían puntos muy complicados de diferenciar. Sobre todo la diferenciación entre delante y detrás nos trajo un verdadero dolor de cabeza.

Intentamos conservar el máximo rango dinámico posible para tener una ambientación lo más cinematográfica que pudiéramos pero lo cierto es que el medio de exhibición está muy lejos de unas condiciones ideales de audición (en el metro con el teléfono móvil y unos auriculares, por ejemplo) así que tuvimos que sacrificar mucha dinámica a favor de una sonoridad que asegurara que la pieza se oiría bien en cualquier condición. En esta pista de audición binaural sí tenía colocados medidores tradicionales pero por supuesto, la medida que daban cada vez dependía de la posición del head tracking. Por todo esto, el proceso de mezcla implicó muchas, muchísimas pasadas para asegurar que la pieza no distorsionaría en ningún punto ni mirando en ninguna dirección y apurando al máximo el headroom para lograr la máxima sonoridad posible.” – Jose Luis Lara Romero.

Una vez realizado este tedioso trabajo, mezcla completada y diseñados todos los elementos sonoros interactivos, llegaron a la fase de exportación, donde resolvieron más trabas como retardos, clips, saltos de audio, etc. Al final, el resultado lo podéis comprobar vosotros mismos descargando el episodio. La calidad visual y sonora dan un aspecto totalmente creíble.

En definitiva, la realidad virtual supone una revolución en el mundo del cine y televisión, el espectador se convierte en parte activa de la historia. Esperemos que esta tecnología sea una realidad en muchas de las series y películas que veremos en los próximos años. En cualquier caso, nos quedamos con un gran sabor de boca por el trabajo realizado por Future Lighthouse, expertos en contar historias.

Lorient

#11 » Respuesta a Robertogeek #7 19 SEP 2016 23:04

Si no es cuestión de que nos animéis a verlas en Gear, ni que no le demos una oportunidad en Gear. Es que si no tenemos Gear no podemos ni animarnos ni darle la oportunidad.

Se entiende que el presupuesto es el que es, y que no se puede sacar en más plataformas. Al igual que se entiende que si se saca un producto para una única plataforma, solo lo consumirán aquellos que la dispongan. Si es realmente bueno, sin duda en la próxima tendréis más presupuesto, y así lo disfrutaremos el resto de plataformas.

Robertogeek

#12 20 SEP 2016 8:08

Como bien decis, es interactivo y no se puede ver solo el video. Para los que esteis en Madrid, en el espacio VR de la fundación Telefónica en Gran Via, podeis acercaros en cualquier momento a disfrutar de esta y otras experiencias.

Ojala tenga algun recurso libre para generar una app para Oculus y HTC.

Gracias por vuestras respuestas!