Oculus muestra cómo la IA mejora los avatares y el tracking de manos

3 MAY 2018 15:00

De cara a mejorar la experiencia social en realidad virtual, Oculus mostró algunos de sus avances en el seguimiento de manos y los avatares.

Durante la segunda keynote de la F8, que tuvo lugar ayer, Oculus dio a conocer el prototipo Half Dome, un visor que mejora aspectos como el FOV y la distancia de enfoque que tenemos a día de hoy, pero durante la charla también mostraron avances en otros campos, como el de la interacción y los avatares, viéndose ambos beneficiados por el uso de la inteligencia artificial para determinadas características, como puede ser mejorar el sincronismo de los labios de un avatar respecto a la voz de la persona real. De hecho, en esta charla presentaron PyTorch 1.0, un framework de código abierto para implementar soluciones de IA, el cual utilizaron en el caso de los labios del avatar al hablar.

Algunas de las áreas de investigación en las que trabajan.

El primero de los puntos que abordaron fue el tema de los avatares, los cuales nos permiten comunicarnos con otras personas e interactuar con el mundo virtual. Facebook, en este caso, mostró algunos ejemplos de cómo la IA puede ayudar a sincronizar los labios de los avatares para que se adapten a cualquier idioma y hagan más real la experiencia.

Ejemplo de los nuevos avatares más realistas de Facebook Spaces.

Facebook también mostró un ejemplo de dos personas charlando en realidad virtual con avatares fotorrealistas animados en tiempo real, aunque no dieron más detalles sobre cómo lo habían llevado a cabo.

Ejemplo con avatares foto realistas (mostrados en el centro del vídeo).

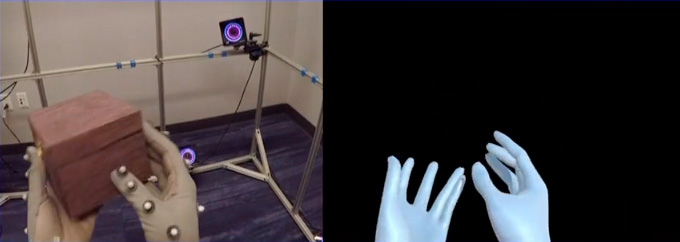

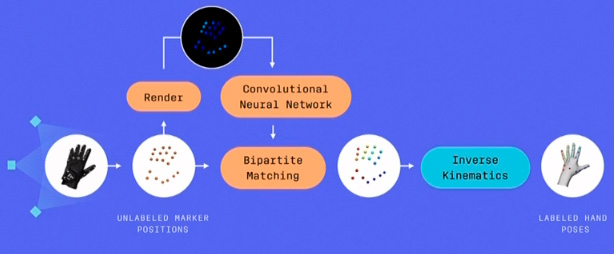

En cuanto a las interacciones con las manos, Oculus describió un sistema de seguimiento basado en visión artificial que utiliza un algoritmo de aprendizaje automático que, según indicaron, es más preciso que cualquier otro método para el seguimiento de una mano, de las dos manos o de la mano interactuando con objetos.

Guantes con marcadores y cámaras OptiTrack.

Guantes con marcadores y cámaras OptiTrack.

Sistema utilizado para identificar la posición de las manos.

Para entrenar la red neuronal, utilizaron unos guantes con marcadores y la tecnología de tracking de OptiTrack, algo que ya habíamos visto antes en el laboratorio de Oculus. El sistema después se basa en captar con una cámara las manos para identificar la posición correcta de éstas, por lo que no utilizan guantes con marcadores.

Tasa de aciertos en comparación con otros sistemas.

Tasa de aciertos en comparación con otros sistemas.

Como podemos ver en el gráfico anterior, el sistema se beneficia enormemente cuando llevamos a cabo tareas de interacción con otros objetos o incluso con las dos manos a la vez, y es capaz de ofrecer un 100% de aciertos para una sola mano.

Otro de los avances que presentaron, en este caso en el terreno de la captura de la realidad, fue el prototipo de un sistema para crear reconstrucciones 3D de lugares reales. El sistema utiliza, probablemente, campos de luz para generar incluso los reflejos de los espejos de forma realista.

A la izquierda la habitación real y a la derecha la reconstrucción 3D.

No sabemos cuándo acabarán llegando estos avances al terreno comercial, pero igual que con el prototipo Half Dome, nos sirve para hacernos una idea de los posible avances que integrarán las próximas generaciones de dispositivos de realidad virtual.

cercata

Visores

#1 3 MAY 2018 15:06

Lo de las manos mola, pero no dicen que "latencía" tiene la cosa por el momento.

OvertKill

Visores

#2 3 MAY 2018 15:48

El tema de los avatares foto realistas mola. Parece que han usado algún sistema de fotogrametría para capturar las cabezas, un seguimiento por puntos de las cejas, pupilas y detección de parpadeo, lo cual explicaría el cable extra que tienen los visores que seguramente será una o dos pequeñas cámaras dentro del visor. Esto unido a un lypsinc muy parecido al que seguro que están usando ya en los avatares de facebook... y listo!

Con esto realmente el futuro los avatares foto-realistas en la vr-social o gaming está prácticamente asegurado. Son detalles que en cuantos implementen en el software y hardware de sus próximos visores vamos a flipar en colores...

gotmog

Visores

#3 3 MAY 2018 20:36

Lo de las manos es con los guantes o sin , como los de leap motion?

tristanc

Visores

#4 » Respuesta a gotmog #3 3 MAY 2018 21:29

Entiendo que sin guantes como leap motion.

OvertKill

Visores

#5 » Respuesta a gotmog #3 3 MAY 2018 21:58

A mi me parece que es con guantes no ? De ahí las "bolitas" esas, que parece un sistema parecido al que ya habían mostrado, con el añadido de la IA para mejorar y evitar la perdida de la interpretación de las manos.

Harold

Visores

#6 » Respuesta a OvertKill #5 3 MAY 2018 22:30

@gotmog

Es como Leap Motion, lo que se ve de los guantes es para entrenar a la red neuronal que luego ayuda a mejorar la precisión de la detección de la posición de la mano.

Cdaked

Visores

#7 » Respuesta a Harold #6 4 MAY 2018 1:36

¿Alguien se ha preguntado por las cámaras? Porque las cámaras Optitrack de esas bolitas valen miles de dólares. ¿Qué cámaras piensan usar en el headset?

Imagino que será sin "bolitas" lo de las bolitas debía ser para llenar da datos la IA y que aprendiera como iban los dedos. Habrá que ver con qué salen y cuándo.